公司名称:元越-服务器_存储-量子创新(北京)信息技术有限公司

联系方式:010-62462728

公司地址:海淀区高里掌路3号院24号楼二层

公司邮箱:support@iaserver.com

统一存储解决方案

需求:

一体化存储,同时支持媒资应用,虚拟化应用,数据库应用以及对象存储归档业务。具体要求如下:

提供200TB左右的空间用于媒资文件存储(CIFS)

提供30TB左右的空间用于NFS虚拟化应用

通过FC-SAN方式,提供5TB空间用于数据库应用

对象归档应用容量分别为5PB,10PB和15PB

系统规划:

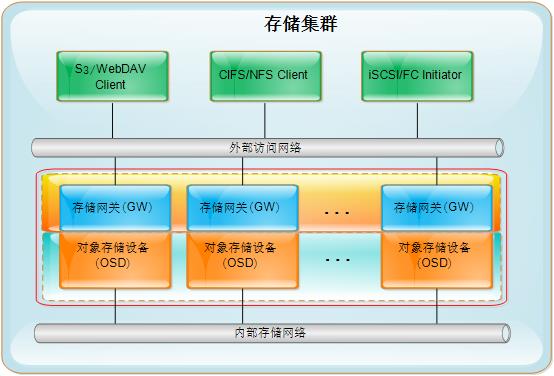

为避免烟囱式的存储模式,将各类存储应用纳入到一个统一的存储平台下来进行管理。本案中采用可横向扩展的全对称架构的分布式存储集群解决方案。集群结构图如图-1所示:

图-1

系统中的每个物理节点均为等价节点,包含对象存储设备(OSD)模块和存储网关(GW)模块。其中OSD模块负责存储实际数据,GW模块提供各种标准接口供客户端访问,包括有:Amazon S3接口,NAS访问接口以及iSCSI/FC SAN接口。所有节点均为等价节点,整个存储集群没有单点故障。且所有的存储网关也构建成一个集群,客户端可以从任意一个存储网关接入存储,并可访问存储集群中各节点上的数据。

考虑到本案存储空间需求巨大,设备节点均采用4U 72盘位的高密度存储服务器进行构建。每台存储服务器中配备不同型号的磁盘,通过存储虚拟化技术,依据不同应用的特性,将底层磁盘划分为不同的存储资源池,提供给不同的业务使用。同时所有的存储资源均可通过任一节点进行上的Web控制台进行管理。

存储池规划:

图-2

本方案采用存储虚拟化技术,将底层存储资源按照应用需求,规划为不同的存储资源池,其规划示意图如图-2所示。为响应不同业务需求,每台物理节点均配置有不同性能的存储介质,包括SSD固态盘,高转速SAS盘以及大容量SATA盘等。通过软件定义的方式,将大容量存储介质配置为归档存储池,将高性能存储介质配置为在线或近线业务存储池。本案中,针对不同业务的规划方案如下:

针对归档业务,将每台设备上的所有大容量SATA盘构建成一个S3对象存储池,归档服务器通过S3接口,直接存储归档文件

针对DB业务,规划部分节点,构建DB存储池,该存储池由各节点中的SSD固态盘加高转速SAS盘构建而成,提供DB应用需要的高IOPS和低延时特性

针对虚拟化业务,可规划部分节点,构建NFS存储池,该存储池通过SSD固态盘加SATA盘构建出高IOPS的存储池,确保虚拟化应用的性能

针对媒资业务,可规划部分节点,构建CIFS存储池,该存储池可采用SAS盘或SSD固态盘加大容量SATA盘,提供业务所需的高带宽,低延时需求

数据安全性规划:

对于数据安全性,本案从两个维度进行数据安全性规划。

从单台物理设备的数据安全维度,每个存储池中的磁盘,通过RAID冗余方式,确保单块磁盘故障不会影响影响节点的数据安全和数据访问

从集群的数据安全维度,兼顾效率和成本因素,本案中采用副本和纠删码机制并存的方式对集群数据进行保护。

针对在线和近线业务,包括DB,虚拟化以及媒资业务,采用多副本机制进行保护,可提供足够的访问性能。本方案中副本数可动态调节,从2副本到10副本不等,用户可针对不同业务为其配置不同的安全级别;副本数调解时,不会中断任何正在运行的业务。本方案的默认副本数为3,即任意两台设备出现故障下线均可确保数据安全不丢失。

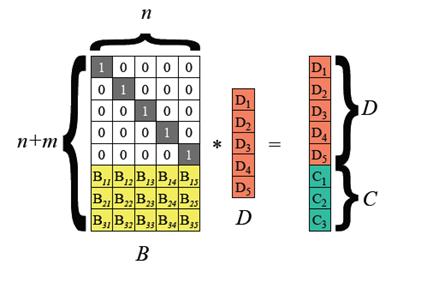

针对离线业务,主要是S3对象存储归档业务,采用纠删码技术进行数据保护,纠删码技术是一种类似节点间RAID的技术,其技术原理如下:

图-3

通过编码矩阵将数据D进行编码,假设D1,D2,…Dn是存储于n个节点上的数据,编码后生成n个数据和m个校验和。任何小于等于m个数据丢失后,可通过剩余的数据乘以编码矩阵的逆矩阵来计算获得原始数据。因此对于有n个数据节点的存储集群而言,原始数据仅需保存一份,并通过就删码的方式额外保存m个校验码,即可确保在损坏节点数不超过m个节点的前提下,确保数据的安全性。而整体的存储空间容量就是m+n个节点。如果是副本机制要达到同样的安全级别,节点数需要达到m*n个,因此针对大容量,冷数据存储,纠删码是一个非常有效的节约成本的存储方案。本案中将采用N+2的纠删码方案,确保任意损坏两台物理节点,数据依然可确保安全。

高可用性规划:

作为分布式存储集群来说,需要处理各种异常情况来确保存储的持续可用。本方案中针对以下几类异常情况,分别给出高可用方案。

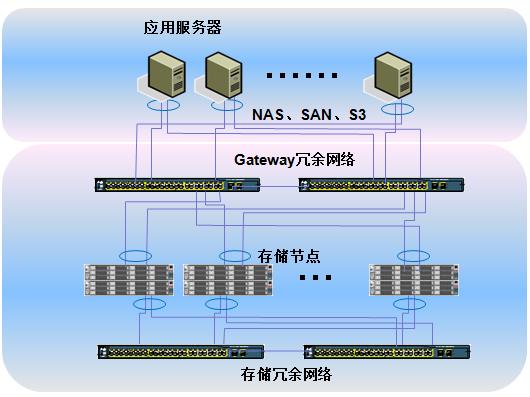

网络故障:分布式存储集群的各个节点通过网络设备互相连接,在一个较大规模的分布式存储网络中,交换机往往会变成一个单点故障点。本方案采用网络冗余策略,确保任意一台交换机掉电或者宕机时,存储集群依旧可以对外提供服务。部署拓扑图如下:

图-4

存储节点故障:

存储节点故障可分为存储节点OS故障和存储节点数据故障。

针对存储节点OS故障而数据并未损坏的场景,客户仅需重新安装存储存储节点的OS,通过导入配置并执行恢复脚本,即可将节点重新加入到集群中,不会引发大量的数据迁移动作。

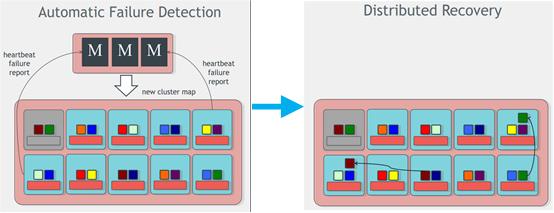

针对存储节点数据故障,集群会自动侦测到故障点,对于多副本的存储池,系统会自动进行自我修复,将故障节点中的数据自动复制到健康节点中,确保数据最终的副本数和预先配置的副本数一致,其过程如下图所示:

图-5

左图中是集群自动侦测到某个节点数据出现故障,右图中显示该节点上的数据被自动重新分布到别的健康的节点中。

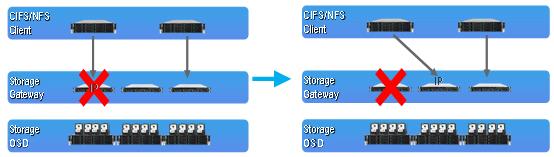

存储网关故障:

基于系统架构,每个节点上都可以开启存储网关功能。每个存储网关都可以访问底层所有的存储数据,存储网关之间也形成了一个集群。虽然应用服务器或客户端在某一时刻是通过某个存储网关来访问存储资源,但即使是该存储网关出现问题时,存储网关集群通过IP漂移技术,依旧可以由其他的存储网关接管故障存储网关的业务,而作为应用服务器和客户端,无需修改和重新配置就可无缝迁移到健康的存储网关上继续访问存储集群。

图-6

存储资源池容量规划:

根据需求可知,DB、NFS以及CIFS应用需求比较固定,而S3归档业务的空间容量会有所不同。因此针对S3归档业务的容量,分别规划出集群节点数和各存储资源池容量如下:

5PB归档容量场景

节点编号 存储资源池类型 磁盘数量 RAID规格 副本规格 实际可用容量

1 - 6 DB存储池 SSD + 6*900GB SAS RAID10 3副本 5.4TB

7 - 12 NFS存储池 SSD + 6*6TB SATA RAID10 3副本 36TB

1 - 12 CIFS存储池 SSD + 7*6TB SATA RAID5 3副本 72TB

13 - 20 CIFS存储池 2 * (SSD + 7*6TB SATA) RAID5*2 3副本 144TB

1 - 20 S3归档存储池 3 * 18*6TB RAID5*3 N+2纠删码 5508TB

合计:DB: 5.4TB

NFS:36TB

CIFS:288TB

S3归档:5508 TB

总结点数:20

10PB归档容量场景

节点编号 存储资源池类型 磁盘数量 RAID规格 副本规格 实际可用容量

1 - 5 DB存储池 SSD + 8*900GB SAS RAID10 3副本 6TB

6 - 11 NFS存储池 SSD + 9*3TB SATA RAID5 3副本 48TB

12 - 32 CIFS存储池 SSD + 9*6TB SATA RAID5 3副本 336TB

1 - 32 S3归档存储池 4 * 15*6TB RAID5*4 纠删码 10080TB

总节点数:32

15PB归档容量场景

节点编号 存储资源池类型 磁盘数量 RAID规格 副本规格 实际可用容量

1 - 7 DB存储池 SSD + 7*600GB SAS RAID5 3副本 8.4TB

8 - 17 NFS存储池 SSD + 7*2TB SATA RAID5 3副本 36TB

18 - 47 CIFS存储池 SSD + 7*4TB SATA RAID5 3副本 225TB

1 - 47 S3归档存储池 5 * 13*6TB RAID5*5 纠删码 16200TB

总节点数:47